Содержание

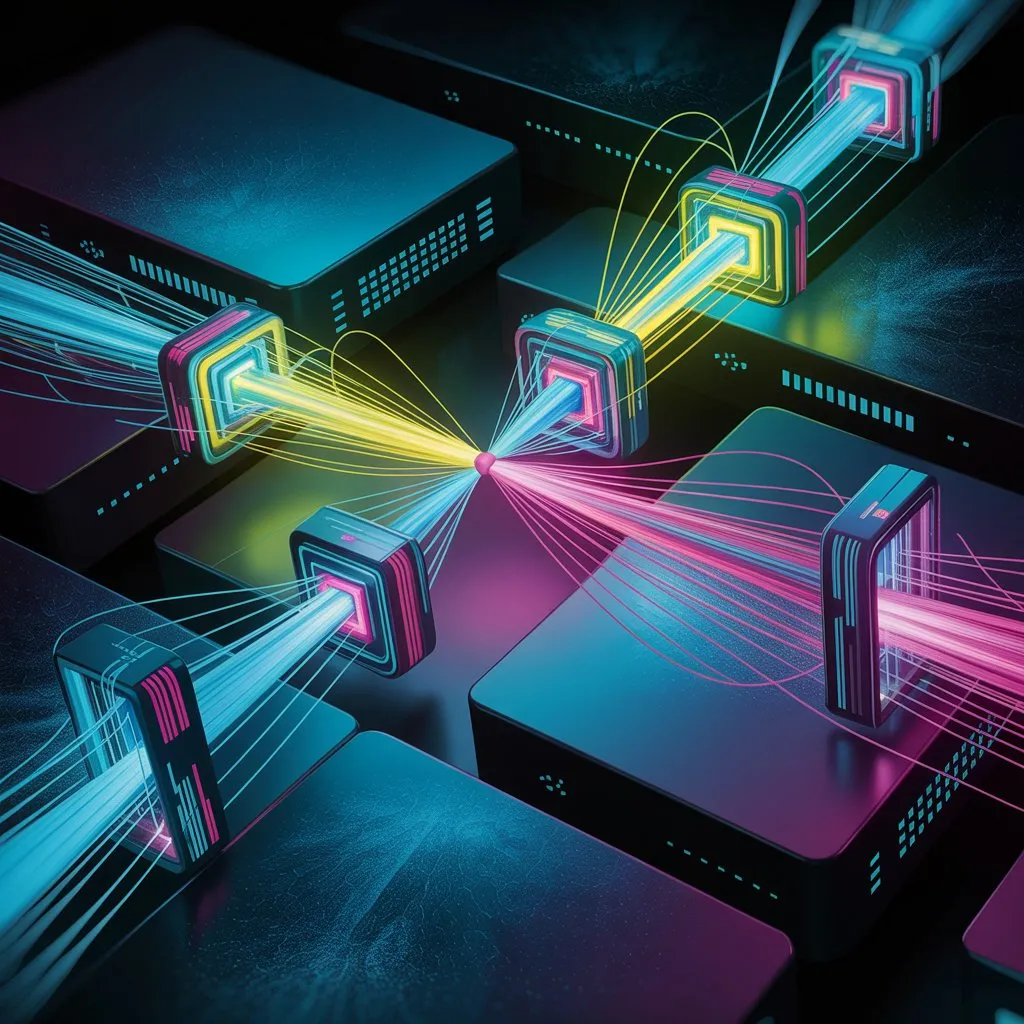

Представьте себе симфонический оркестр, где каждый музыкант играет на своём инструменте. Но без дирижёра звучание будет хаотичным — кто-то начнёт играть слишком громко, кто-то опоздает, а кто-то вообще уйдёт в сторону. Теперь перенесите эту аналогию в мир IT: вместо музыкантов здесь серверы, вместо нот — сетевые запросы, а роль дирижёра выполняет балансировщик нагрузки. Это не просто элемент системы, это её сердце, обеспечивающее ритм, согласованность и стабильность.

В этой статье мы подробно расскажем, как устроен этот «дирижёр» цифрового мира, какие методы и алгоритмы он использует, как взаимодействует с другими компонентами инфраструктуры и почему его роль так важна в современных масштабируемых системах.

Что такое сетевая балансировка и зачем она нужна

Балансировка сетевой нагрузки — это процесс равномерного распределения входящих сетевых запросов между несколькими серверами или вычислительными ресурсами. Звучит технично, но давайте разберёмся простым языком.

Представьте, что вы открыли кофейню. В первый день работы всё проходит идеально: один бариста успевает обслуживать всех клиентов. Но со временем популярность кофейни растёт, очереди увеличиваются, и одному человеку становится не справиться. Что делать? Правильно — нанять ещё одного бариста. Теперь нужно придумать, как делить клиентов между двумя сотрудниками. Можно по очереди, можно по скорости работы, можно по типу заказа (эспрессо — первому, капучино — второму). Именно этим занимается балансировщик нагрузки, только вместо людей он управляет серверами.

Если говорить формально, то балансировка позволяет:

- Избежать перегрузки отдельных серверов;

- Обеспечить высокую доступность сервисов, даже если часть серверов выйдет из строя;

- Увеличить пропускную способность всей системы;

- Снизить время отклика для конечных пользователей.

Например, если ваш сайт внезапно стал популярным после публикации в соцсетях, и на него хлынул поток новых пользователей, балансировщик поможет справиться с ростом нагрузки, добавив новые серверы в кластер и равномерно распределив трафик между ними.

Роль балансировщика в обеспечении надёжности и производительности

Балансировщик нагрузки — это программный или аппаратный компонент, который управляет потоком сетевого трафика. Он выполняет несколько критически важных функций:

- Обеспечение отказоустойчивости: если один из серверов выходит из строя, балансировщик автоматически перенаправляет трафик на рабочие узлы. Например, если один из ваших серверов перестал отвечать, система сама направит все новые запросы на другие машины, чтобы пользователь даже не заметил сбоя.

- Равномерное распределение нагрузки: предотвращает перегрузку отдельных серверов за счёт оптимального распределения трафика. Это как регулировщик движения на перекрёстке: если одна полоса загружена, он направляет транспорт на менее загруженные участки дороги.

- Масштабируемость: позволяет динамически добавлять новые серверы в инфраструктуру без необходимости ручной настройки маршрутов. Представьте, что в вашей кофейне стало очень много клиентов. Вы можете быстро нанять ещё двух бариста, и система сама начнёт распределять посетителей между всеми сотрудниками.

- Защита от DDoS-атак: фильтрует подозрительный трафик и задерживает обработку потенциально опасных запросов. Если злоумышленник попытается перегрузить ваш сайт искусственным трафиком, балансировщик сможет распознать аномалии и защитить систему.

Также важно понимать, что балансировщик может быть реализован как программно (например, через Nginx или HAProxy), так и аппаратно (например, F5 BIG-IP). Облачные решения, такие как Google Cloud Load Balancer или AWS Elastic Load Balancer, предоставляют готовые сервисы, которые позволяют создавать и управлять балансировщиками всего за несколько кликов.

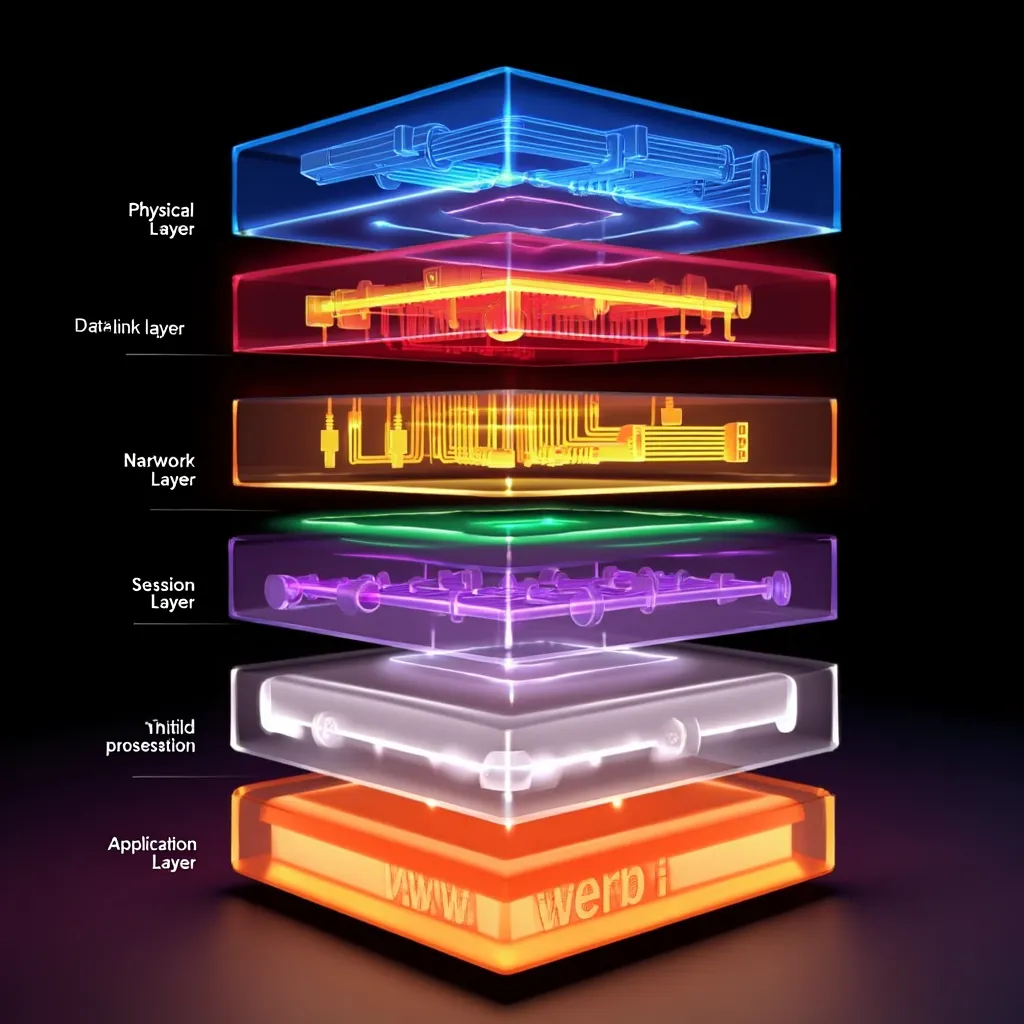

Уровни работы балансировщика в модели OSI

Для понимания того, как балансировщики работают на разных уровнях сети, важно обратиться к модели OSI (Open Systems Interconnection), которая делит сетевые процессы на семь уровней. Балансировщики могут работать на различных уровнях этой модели, что влияет на их функциональность и возможности.

Физический уровень (L1)

Это самый нижний уровень, отвечающий за передачу сырых битовых потоков по физическим каналам связи. Балансировщики здесь обычно не работают, но всё же зависят от качества линий связи. Представьте, что вы слушаете музыку через наушники — если провод оборван, никакое программное обеспечение не поможет. Так и здесь: если сеть "обрывается", балансировщик не сможет выполнять свою работу.

Канальный уровень (L2)

На этом уровне данные группируются в кадры и передаются между устройствами одной локальной сети. Балансировщики могут использовать MAC-адреса для перенаправления трафика. Другими словами, L2 помогает понять, куда именно отправлять данные внутри одной локальной сети.

Сетевой уровень (L3)

Отвечает за маршрутизацию данных между различными сетями. IP-адресация используется именно на этом уровне. Пример: маршрутизаторы и некоторые виды балансировщиков используют L3 для выбора целевого сервера. То есть, если вы заходите на сайт, ваш запрос проходит через множество маршрутизаторов, пока не достигнет нужного сервера.

Транспортный уровень (L4)

Именно здесь работают большинство балансировщиков. Они анализируют TCP/UDP-порт и состояние соединений. Примеры использования: Nginx, HAProxy. Эти инструменты могут принимать решение, куда направить запрос, основываясь на том, какой порт используется (например, 80 для HTTP, 443 для HTTPS) и какова текущая нагрузка на сервер.

Прикладной уровень (L7)

На этом уровне балансировщики работают с содержимым запросов, например, с HTTP-заголовками, URL, cookie-файлами и т.д. Такие решения позволяют гибко управлять трафиком, основываясь на контексте запроса. Например, вы можете настроить балансировщик так, чтобы все запросы к /api/* направлялись на backend-серверы, а к /static/* — на CDN.

Методы балансировки нагрузки

Существует множество способов распределения трафика между серверами. Выбор конкретного метода зависит от типа приложения, характера нагрузки и требований к отказоустойчивости. Рассмотрим наиболее распространённые:

Оценка доступности серверов

Балансировщик периодически отправляет health check-запросы на серверы, чтобы проверить их работоспособность. Если сервер не отвечает, он исключается из пула до восстановления.

# Пример health check в конфигурации Nginx

upstream backend {

server backend1.example.com;

server backend2.example.com;

keepalive 32;

}

Управление количеством активных соединений

Балансировщик ограничивает число одновременно открытых соединений с каждым сервером, чтобы избежать перегрузки. Это особенно важно для долгих операций, таких как работа с базами данных или обработка видео.

Географическая балансировка

Запросы направляются на ближайший к пользователю сервер. Это снижает задержку и повышает скорость отклика. Например, если пользователь находится в Москве, ему будет назначен сервер в Европе, а не в Америке.

Балансировка по времени отклика

Выбирается сервер, который отвечает быстрее всего. Это особенно эффективно при наличии гетерогенной инфраструктуры, где серверы имеют разную мощность и производительность.

Хеширование

Трафик направляется на сервер в зависимости от IP-адреса клиента или идентификатора сессии. Позволяет сохранять сессию пользователя на одном сервере (sticky sessions).

# Пример настройки sticky session в Nginx

upstream backend {

hash $request_header_or_cookie consistent;

server backend1.example.com;

server backend2.example.com;

}

BGP Anycast

Используется для глобального распределения трафика. Все серверы используют один и тот же IP-адрес, а маршрутизаторы выбирают ближайший доступный сервер. Это как единая телефонная горячая линия, которая перенаправляется в ближайший офис компании.

Алгоритмы балансировки нагрузки

Алгоритмы — это "мотор" балансировщика. От них зависит, насколько эффективно будет распределяться трафик и как быстро система сможет реагировать на изменения в нагрузке.

Round Robin (циклическое распределение)

Простейший алгоритм, при котором запросы направляются поочерёдно на каждый сервер из списка. Может использоваться взвешенный Round Robin, где сервера получают разное количество запросов в зависимости от их мощности.

# Пример Round Robin в HAProxy

backend app

balance roundrobin

server s1 192.168.0.10:80 check weight 3

server s2 192.168.0.11:80 check weight 1

В этом примере сервер s1 получает в три раза больше запросов, чем s2, потому что его вес указан как 3.

Least Connections (наименьшее число соединений)

Запросы направляются на сервер с минимальным числом активных соединений. Особенно полезно для долгих операций, таких как работа с базами данных.

# Пример Least Connections в HAProxy

backend app

balance leastconn

server s1 192.168.0.10:80 check

server s2 192.168.0.11:80 check

IP Hash

Сервер выбирается на основе хэша IP-адреса клиента. Гарантирует, что один и тот же пользователь всегда будет попадать на один сервер. Полезно, если требуется сохранить состояние сессии.

URI Hash

Используется для распределения трафика по URL-пути. Например, все запросы к /api/* направляются на backend-серверы, а к /static/* — на CDN.

Балансировка нагрузки и проксирование: чем отличаются

Хотя термины балансировщик нагрузки и прокси-сервер часто путают, они имеют разные цели и функции.

Обратный прокси принимает внешние запросы и направляет их на внутренний сервер. Он может выполнять дополнительные задачи, такие как:

- Кеширование;

- Шифрование (SSL/TLS);

- Защита от DDoS;

- Сжатие данных.

Пример простого reverse proxy на Nginx:

server {

listen 80;

location / {

proxy_pass http://backend_server;

}

}

Балансировщик нагрузки работает как продвинутый reverse proxy, но умеет распределять трафик между множеством серверов. Он может быть реализован как программно (например, через Nginx или HAProxy), так и аппаратно (например, F5 BIG-IP).

Преимущества облачного балансировщика нагрузки

Облачные балансировщики нагрузки предоставляют массу преимуществ, особенно для масштабируемых и высоконагруженных приложений:

- Автоматическое горизонтальное масштабирование: возможность мгновенного добавления новых серверов в инфраструктуру.

- Высокая доступность: облачные платформы обеспечивают резервирование и отказоустойчивость на уровне сервиса.

- Интеграция с другими сервисами: мониторинг, логирование, защита от атак, шифрование и многое другое.

- Глобальная маршрутизация: возможность распределять трафик между дата-центрами по всему миру.

- Экономия на эксплуатации: нет необходимости содержать собственный парк оборудования и администрировать его.

Например, Google Cloud Load Balancer позволяет создать балансировщик всего за несколько кликов и автоматически распределять трафик между виртуальными машинами в разных регионах.

Заключение

Балансировщик нагрузки — это не просто промежуточный элемент между клиентом и сервером, а полноценный "умный маршрутизатор", от которого зависит стабильность, производительность и безопасность всей системы. Его правильно настроенные алгоритмы и методы позволяют эффективно управлять сотнями и тысячами серверов, масштабировать инфраструктуру в режиме реального времени и обеспечивать высокую доступность сервисов даже в условиях экстремальной нагрузки.

Понимание принципов работы балансировщика, уровней OSI, алгоритмов распределения трафика и особенностей облачных решений — ключ к построению отказоустойчивых и производительных архитектур будущего. Независимо от того, разрабатываете ли вы маленький стартап или масштабную корпоративную систему, балансировщик нагрузки станет вашим верным союзником в мире распределённых вычислений.